Prüf- und Messtechnik zur Validierung der Leistung und Konformität von Post-Quanten-kryptographischen Systemen

Die in der Entwicklung von Quantencomputern gemachten Fortschritte bedeuten, dass Verfahren der Elliptischen-Kurven-Kryptographie (ECC) wahrscheinlich in etwa 5 Jahren entschlüsselt werden können. Diese Entwicklung betrifft nicht nur die Rechenleistung (der Kookaburra-Prozessor von IBM soll noch in diesem Jahr mehr als 4.000 Qubit erreichen), sondern auch für die Fehlerkorrektur. Beispielsweise ist der Google-Computer Willow mit seinen 105 Qubit und der daraus resultierenden besseren Fehlerkorrektur in der Lage, Berechnungen, die selbst für die führenden Supercomputer völlig unmöglich sind, in weniger als 5 Minuten durchzuführen.

Diese Fortschritte sind auch den Cyberkriminellen bekannt, sodass die Harvest Now, Decrypt Later (HNDL) Strategie zunehmend Anwendung findet.

In diesem Blog werde ich die drei wichtigsten Schutzalgorithmen der Post-Quanten-Kryptographie (PQC) sowie die Validierungsverfahren und Technologien erläutern, die deren Wirksamkeit gewährleisten.

Wenn Sie an mehr Einzelheiten zu einem Aspekt dieses Blogs interessiert sind, empfehle ich Ihnen das Whitepaper, das Sie hier herunterladen können.

NIST-Algorithmen

Zum Zeitpunkt der Veröffentlichung dieses Blogs hat das US-amerikanische National Institute of Standards and Technology (NIST) die drei Algorithmen: FIPS 203, 204 und 205 standardisiert. Ein vierter Algorithmus wurde angekündigt, aber verschoben, da einerseits eine konsistente Implementierung zu schwierig, andererseits aber auch eine starke Gefährdung durch Side-Channel-Angriffe gegeben war.

Jeder Algorithmus weist geringfügige Funktionsunterschiede auf. FIPS 203 und FIPS 204 nutzen gitterbasierte Verfahren, um eine sichere Verbindung aufzubauen bzw. die Herkunft und Authentizität einer Nachricht nachzuweisen. Als Alternative zu FIPS 204 verwendet FIPS 205 die hashbasierte Kryptographie, ist jedoch langsamer und hat eine größere Signatur.

Die NSA und andere nationale Sicherheitsbehörden der USA schreiben die Einführung dieser Algorithmen vor. Nationale Sicherheitssysteme sind verpflichtet, den Übergang zur PQC bis 2030 abgeschlossen zu haben. Dabei ist es unerheblich, ob sie softwarecodierte Algorithmen (PQC), hardwarebasierte Methoden zum Schlüsselaustausch mit optischen Übertragungsstrecken (Quantenschlüssel-Austausch, QKD) oder für Übergangsarchitekturen ein hybrides Konzept verwenden.

Leider scheint man mit der weltweiten Vorbereitung zur Abwehr von Quanten-Angriffen im Rückstand zu sein.

Allerdings haben Branchenverbände mit der Post-Quantum Cryptography Alliance (PQCA) und der Post-Quantum Telco Network Task Force (POTN) bemerkenswerte Foren geschaffen, die sich großer Unterstützung erfreuen.

Validierung der Konformität

Doch reicht es nicht, diese Algorithmen zu implementieren. Auch wenn ihre mathematische Robustheit nachgewiesen wurde, muss jede einzelne Implementierung getestet werden, um deren Konformität („Compliance“) sicherzustellen.

Da drei unterschiedliche Konzepte (QKD, PQC, Hybrid) verfolgt werden, wird es auch keine universelle Testlösung geben, die alle Anforderungen erfüllen kann.

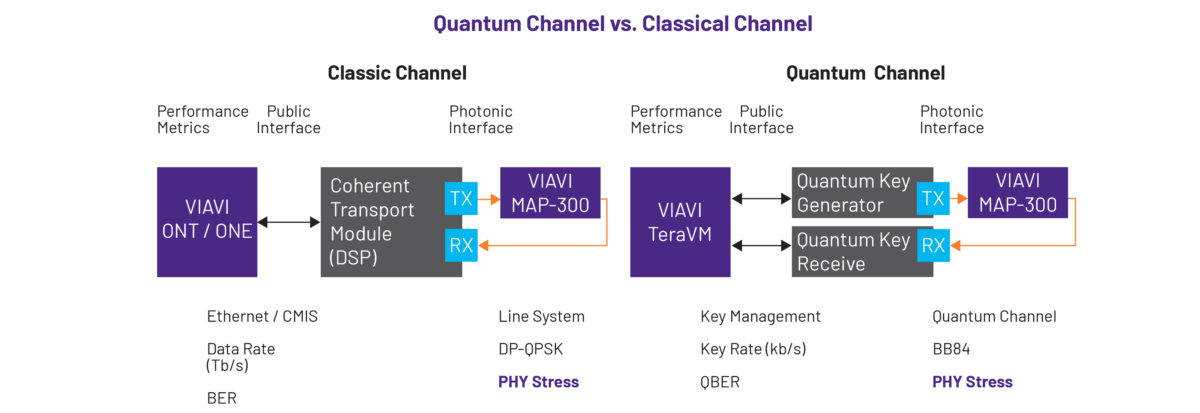

Bei QKD-Systemen muss die Qubit-Bitfehlerrate (QBER) des geprüften Quanten-Kanals gemessen werden, wobei eine hohe QBER ein Hinweis auf einen Lauschangriff sein kann. Auch sind Belastungstests durchzuführen, bei denen ein emuliertes Netzwerk sowie mehrere kontrollierte optische Lastfaktoren zum Einsatz kommen. Diese Tests müssen sich bis auf die Dienste-Schicht erstrecken, um sicherzustellen, dass das Schlüsselmanagement-System die Anwendungen resilient bedienen kann.

Demgegenüber besteht bei PQC-Systemen die größte Sorge darin, dass sich die längeren Verschlüsselungsschlüssel negativ auf die Leistung und die Architektur auswirken, da die Algorithmen tendenziell aufwändiger zu verarbeiten sind. Daher muss die Berechnungseffizienz getestet werden, um die Verschlüsselung und Geschwindigkeit der Schlüsselgenerierung sowie Schwankungen in der Schlüssellänge zu prüfen. Auch hier werden umfassende Belastungstests benötigt, darunter die Emulation der Nutzer und Nutzungs-/Verkehrsmuster zur Überwachung der kritischen Kennwerte (KPI), wie Latenz und Durchsatz unter Lastbedingungen. Zu guter Letzt müssen die Tests auch Ausfallszenarien umfassen, wenn beispielsweise die PQC-Schlüsselauswahl nicht korrekt abgestimmt ist oder eine Partei kein PQC unterstützt.

Bei hybriden Systemen müssen die oben genannten Verfahren vor dem Hintergrund einer erhöhten Komplexität berücksichtigt werden. Funktionsprüfungen ermöglichen, die klassische Quanten-Schnittstelle zu validieren und die Stabilität der Zeitsynchronisation zu kontrollieren. Ebenfalls wichtig sind Sicherheits-/Resilienz-Tests, die die Simulation von Side-Channel-Angriffen umfassen sowie bei Ausfall eines QKD-Links den korrekten Rückfall des Systems auf das PQC-Verfahren prüfen.

Für die Leistungsvalidierung müssen sowohl klassische als auch Quanten-Kennwerte gleichzeitig gemessen werden. In diesem Zusammenhang gilt es, auch die Bitübertragungsschicht zu testen, um sicherzugehen, dass der klassische Quanten-Verkehr ohne Rauschen oder Polarisationseffekte koexistieren kann.

Auch wenn diese Verfahren zahlreiche Ähnlichkeiten zum Testen von klassischen Systemen aufweisen, stellt die photonische Schnittstelle doch völlig anderen Anforderungen. Auch das Ausmaß und die Art der optischen Belastungsfaktoren (Stressoren) verändern die Vorgehensweise.

Die Prüf- und Mess-Plattformen für QKD-, PQC- und hybride Systeme von VIAVI

In diesem Abschnitt gehe ich auf einige Kerntechnologien ein, die es ermöglichen, Post-Quanten-Implementierungen zu testen und zu validieren.

Erneute beginne ich mit den QKD-Systemen und mit deren mehrschichtigem Testprozess. Für die optische Bitübertragungsschicht hat VIAVI die Plattform VIAVI MAP-300 entwickelt. Dieses rekonfigurierbare photonische System wird genutzt, um eine Vielzahl unterschiedlicher leistungs- und spektrumbasierter Lastszenarien, wie sie in Live-Netzwerken anzutreffen sind, zu emulieren. Damit sind die Techniker in der Lage, die Resilienz neuer QKD-Systeme zu validieren.

Insbesondere erlaubt die Plattform, mehrere optische Lastfaktoren, wie das Imband-Rauschen von Verstärkern, Polarisationsstörungen und reflektive Ereignisse, zu generieren, die die QKD-Übertragungsstrecken bis an ihre Grenzen belasten.

Für die Dienste-Schicht wird dagegen die Plattform TeraVM benötigt. Sie ermöglicht, sowohl Clients, die im Vorfeld ausgetauschte Schlüssel (Post-Quantum Preshared Key, PPK) erhalten haben, zu emulieren als auch während der kontinuierlichen Schlüsselrotation die Erlebnisqualität (QoE) unter Last zu testen. Daher kann mit einem solchen System nicht nur die ETSI-Konformität gewährleistet, sondern auch die Resilienz des QKD-Schlüsselmanagement-Systems validiert werden.

Bei den PQC-Systemen ist die Leistung die große Herausforderung. In diesem Szenario bietet sich mit TeraVM Security eine Ausführung des TeraVM-Systems an, um die Auswirkungen der Algorithmen zu testen. Dieses softwarebasierte Tool ist in der Lage, Belastungstests an den mit neuen PQC-Algorithmen verschlüsselten VPN-Kopfstellen auszuführen, indem es viele Zehntausend Nutzer und deren Anwendungsverkehr (Kollaborationstools, Videokonferenzen) emuliert und die resultierende Latenz, den Durchsatz, die MoS-Bewertung und andere KPIs unter Lastbedingungen misst.

Darüber hinaus prüft TeraVM Security Schwankungen in der Schlüssellänge, Schlüsselerneuerungsrunden und weitere PQC-spezifische Kennwerte. Bei hybriden Testszenarien kann das System PQC-fähige Initiatoren gegen einen Non-PQC-Responder testen, um sicherzustellen, dass immer noch ein klassischer VPN-Tunnel aufgebaut ist.

Zur Automatisierung des Workflows sollte die cloudbasierte Plattform VAMOS von VIAVI genutzt werden, da sie das Management der Testkampagnen zur Verbesserung der Ressourcennutzung ermöglicht.

Zu guter Letzt muss die physische Glasfaser-Infrastruktur selbst noch gesichert und überwacht werden. Hier bietet sich das optische Ferntestsystem ONMSi an, um das Glasfasernetz kontinuierlich mit einem optischen Reflektometer (OTDR) abzutasten und Fehlerstellen und Leistungsmängel, die auf einen Abhörversuch hindeuten, automatisch zu erkennen und zu lokalisieren. Ebenfalls möglich ist der Einsatz eines Sensorsystems zur verteilten Temperatur- und Dehnungsmessung (DTSS), um mechanische Belastungen und Temperaturänderungen zu erkennen, die durch eine physische Manipulation verursacht wurden. Beispiele hierfür sind, Faserbiegungen oder Faserbrüche, die einen Angriff anzeigen könnten.